~ヒューマンオーグメンテーションと音楽~

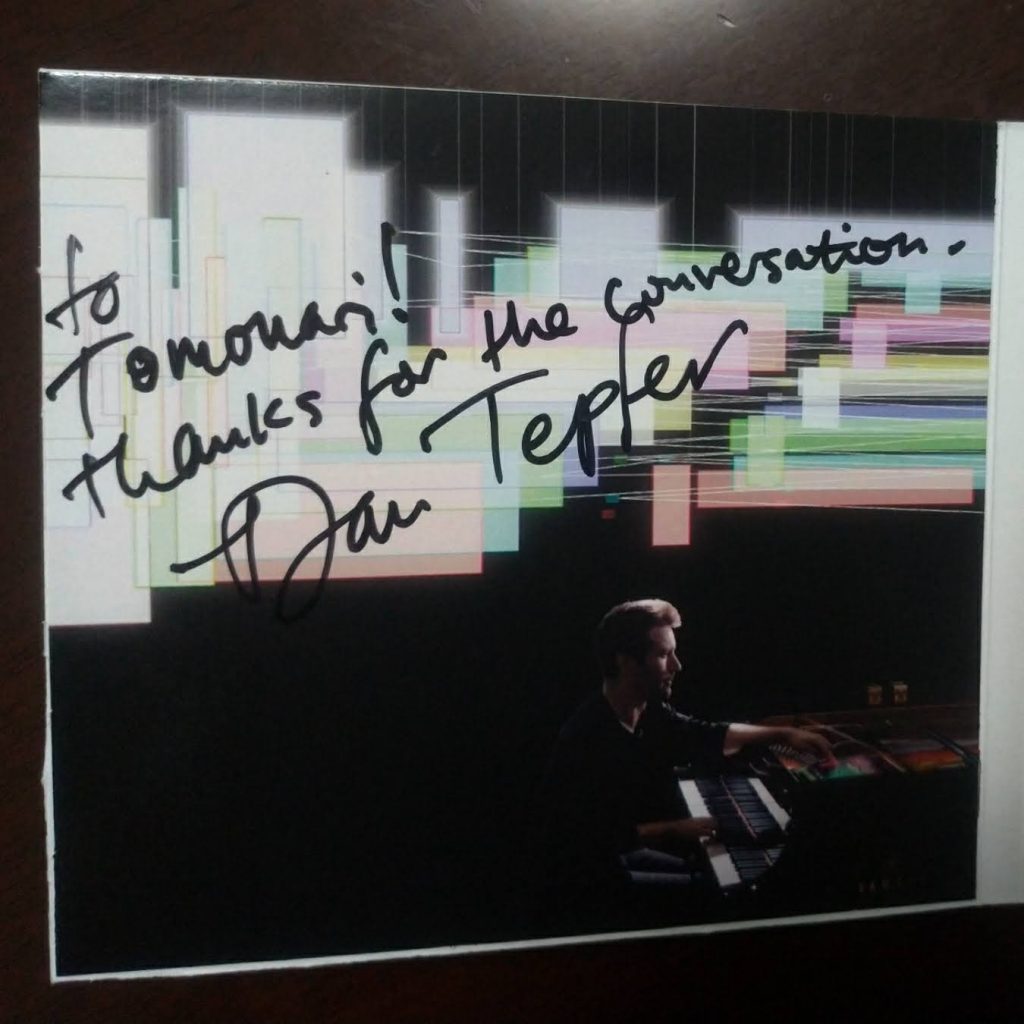

つい先日、2019年6月5日、ブルーノート系列で、ジャズを中心にトップレベルの来日アーティストも出演することで有名な、丸の内コットンクラブに、ジャズピアニスト ダン・テファー率いるピアノトリオが出演した。僕自身は、以前から彼の音楽というか、音楽に対する考え方、そして彼の演奏スタイルに興味を持っていたので、来日にあわせて連絡をとり、ライブの前日にスタジオで練習を終えたばかりの彼と、2時間くらいであろうか、音楽やテクノロジーに関する話をした。これはそのときの話を含め、僕がつらつらと考えたことの記録である。やや長くなりそうなので、2、3回に分けて書こうと思っている。

ここで書きたいのは、テクノロジーと人間の未来、特に、昔は機械には不可能と思われていた「創造」という領域に人工知能(AI)が侵食しつつある今、もっとも創造力が重要だと思われているアートの領域において、テクノロジーと人間との関係性はどうなるか、という考察である。(なお、以下ではテクノロジー、コンピュータ、AIなどの用語を文脈によって変えているが、使い分けは厳密ではない。高度なコンピュータプログラムはいずれにせよAI的な要素がはいってくるし、AIといっても最近はバズワード化して、人によって深層学習に限定して話をする人もいれば、ただのコンピュータ処理と大差ない話をする人もいるし、未来の話をするなら、技術の現状にしたがった厳密な使い分けをしてもあまり意味がないのだ。)

また、ここでの話は、最近テクノロジーの領域で注目されているキーワード「ヒューマン・オーグメンテーション(人間拡張)」あるいは「オーグメンテッド・ヒューマン(拡張人間)」ということについての考察も含んでいる。

とりあえず最初に、彼の演奏映像を1つ見ていただきたい。Natural Machinesというアルバムの中の1曲だ。1分経過したあたりの映像がわかりやすいだろう。「彼が弾いていない鍵盤が動いている」というところがポイントである。

おわかりだろうか。これは、演奏記録および自動演奏機能をもつピアノを使い、彼が演奏をすると、どの音を弾いたか、そのタッチ(鍵盤を押すタイミングや強さ)に基づいてコンピュータプログラムが動き、アルゴリズムに基づいて計算された音を、ピアノが自動演奏している。しかもこのコンピュータプログラムは、彼自身が書いたもの、つまり、彼が考えたアルゴリズムに基づくものである。彼はエジンバラ大学の宇宙物理学科を卒業し、趣味でC言語、JavaScript、Processing等、さまざまなプログラミング言語を使いこなし、さらにはArduino等のハードウェアを使った自動演奏の実験などもするプログラマー、エンジニアでもあるのだ。

音楽的な観点で言えば、彼がジャズピアニストであり、ここで弾いているのは彼自身が作曲したもので、しかも、アドリブ演奏(インプロビゼーション)が入っているということも重要である。日本でピアノを弾くというと、作曲家が書いた楽譜に忠実な演奏をするクラシック音楽を連想する人が多いので若干説明が必要だが、ジャズというのは曲ごとに、ベースとなるメロディーおよびコード(和音)進行はあらかじめ決めておきつつも、アドリブ演奏(その場で演奏者それぞれが、音楽理論的な制約は頭におきつつも、自由にいわば作曲しながら弾く)が中核をなす音楽である。つまり、この映像の中で彼はアドリブで弾き、それに反応してコンピュータが自動演奏するのを聴きながら、(たぶんその自動演奏が彼の発想に影響を与えてさらに増幅するような形で)、曲をつくりながら演奏を進めているのである。

このことが「彼が弾いたものと、コンピュータが自動演奏したものを、後からミックスして録音する」というものとは全く違うことはおわかりだろう。彼がこの場でつくった音を弾き、コンピュータがそれに基づきこの場で音を生成し、彼はそのコンピュータの演奏を聴いてアイデアをふくらませつつ、その後の演奏は進行しているのだ。いわば彼のアイデアとコンピュータからのフィードバックが、まるで合わせ鏡のように、リアルタイムに重層的に拡張している演奏と言っても良い(ついでに付け足すと、彼自身はすさまじいテクニックを持つピアニストでもあるので、そこでプログラムが生成したものを、自分が最初に弾いていた演奏に付け足してしまい、付け足したものを、次の演奏では自分の生演奏だけで再現する、ということもやったりするのだが)。

僕はここに、テクノロジーと人間との、未来の関係性を見る。僕は以前から一部の友人と、「作曲家と演奏家だったら、どちらの方がAIやロボットによって置きかえられていく可能性があるだろう」というような話をすることがあったが、そんな二元論を超え、人間の作曲をリアルタイムにテクノロジーが拡張して、人間とコンピュータとが一体となって生まれた曲を、人間とコンピュータが一体となって演奏していく混然一体としたところに、これまで人間が聴いたこともなかったような、新しい音楽が生まれていくだろう。しかも聴いている人には、普通に人間が演奏しているように聞こえるので、コンピュータによって拡張された音楽とは気づかないかも知れない。これは、以前からあった電子音楽とはまた、まったく別の世界である。

ここで断っておくと、僕自身は音楽の専門家ではない。コンピュータ・サイエンス分野の大学教員で、専門は「コンピュータ・ヒューマン・インタフェース」、言いかえると、コンピュータと人間との新しいインタラクション方法を考えたりすることが専門で、最近であれば「より人間とスムーズに音声で対話ができるスマートスピーカー」を考えたりしている。コンピュータがどんどん知的処理をこなすようになり、たとえば会話ができるロボットなども普及しはじめているので、必然的に「AIが発達したときに、AIと人間との関係性はどうしていくべきか?」ということも考える。

一般の利用者であれば「どうなっていくか?」と予想しようとするのかも知れないが、研究者としては、「どうしていくべきか?」「どういうものを作るべきか?」と考えることになる。たとえば会話ロボットを、人間と対等に独立した人格のように対話するものとしてデザインするか(見た目ではなく、会話のやり方のデザインである)、あくまで人間に寄り添うコンシェルジュのようにデザインするか、それとも余計な知的処理はせずに人間の指示そのままの動作をするようにデザインするか、といった選択である。たとえば人間がスマートスピーカーに、「ねえ、アレクサ」と話しかけたときに、友達のように「何?」と答えるか、コンシェルジュのように「何でしょうか?(何か御用でしょうか?)」と答えるかとか、あるいは「今日の天気はどうだろう?」と聞いたときに「さあ、天気予報によると、雨が降るかも知れないね」と答えるか「今日の15-18時の降水確率は60%です」と答えるかは、技術の問題というよりは、会話デザインのコンセプト、あるいは、「そもそもロボットはどういう存在であるべきだ」と考えるかなどの、設計者の持つ哲学に依るのである。

上の例だけ見ると、「そりゃあコンピュータなんだから、正確にデータ(降水確率60%など)だけを伝えてくれるのが良いに決まってるだろう」と思う人が多いかも知れないが、少し想像力をたくましくして、ある一人暮らしの老人が、自宅のペットロボットに話しかけたときに「今日は天気予報によると雨が降りそうで、ちょっと心配ですね。傘はどうしますか?」と答えてくれるのと「降水確率は60%です。」と答えるのとどちらが好ましいかと言われたら、人によって答は違ってくるだろう。

さて、上で「そもそもコンピュータは、どういう存在であるべきかという設計の哲学」と書いたが、これは最近よくある、「人間の仕事がAIに奪われる」と言った議論とも関係する。AIは人間の存在を置き換えるためのものではなく人間の能力を拡張するためのものと考えるなら、「仕事が奪われる」という話には結びつきにくい。人間が手作業やそろばんでやっていた計算をコンピュータでできるようになったからと言って人間の仕事がなくなるわけではない。単に、人間が自らの力(計算能力)を大きく拡大するツールを手に入れることによって、人間が扱う世界は広がり、新しい仕事はむしろ増える。

こんなことを考えていると、ダン・デファーの演奏はさまざまな考えを刺激する。彼と会って話をしたときは、先ほど述べた「作曲家と演奏家だったら、どちらの方がAIに置きかえられていくだろう?」という話から、演奏家の役割に対する歴史的な捉え方の変化の話になり、さらに、「ちょっと弾いただけでそれを補って、一見、上手そうな演奏に変えてくれるような機能」をどう捉えるか?(僕が、それ風の小さなプログラムを自分で作って、見せたからだ)などの音楽の話にとどまらず、「医師にとって、画像から癌を読みとる能力と、それを患者に伝える能力とどちらが重要か」などさまざまな話になったのだ。

さて、話が少し脱線してきたので、次は、ダン・テファーと話をする中で、彼が今、どのような考えのもとにさまざまな試みをやっているか、これからどうしようと思っていると語ったかについて、書こうと思う。話してみると彼は、音楽だけでなくテクノロジーについて、ものすごく詳しかった。Googleが深層学習を使って芸術を創り出す試みをしているMagentaプロジェクトのリーダーともだいぶ議論をしたということで、テクノロジー領域についても最先端の状況を把握していたのだ(続く)。

おまけ:下記は彼が音楽とアルゴリズムについて語っている映像である。